Stable Diffusion:彻底改变图像生成的开源AI引擎

2025年9月4日 00:02·9466AI精选

Stable Diffusion:彻底改变图像生成的开源AI引擎

在人工智能飞速发展的今天,图像生成技术已成为最具颠覆性的创新领域之一。而在众多AI绘画工具中,Stable Diffusion凭借其开源特性、卓越的性能和高度灵活性,迅速成为了行业标杆。本文将深入解析Stable Diffusion的工作原理、核心优势、应用场景以及未来发展趋势,带您全面了解这一革命性技术。

什么是Stable Diffusion?

Stable Diffusion是由Stability AI于2022年发布的开源扩散模型(Diffusion Model),它能够根据文本描述生成高质量、高分辨率的图像。与传统的GAN(生成对抗网络)不同,Stable Diffusion基于潜在扩散模型(Latent Diffusion Model, LDM),通过在潜在空间中进行去噪操作,大幅降低了计算资源需求,使得普通消费者级GPU也能运行这一强大模型。

这一技术的开源发布彻底打破了大型科技公司对高端AI图像生成技术的垄断,为开发者、艺术家和研究人员提供了前所未有的创作自由和技术透明度。

核心技术原理

1. 扩散模型基础

扩散模型的核心思想是通过逐步去噪过程生成数据。其工作流程分为两个阶段:

前向过程(加噪):通过多次迭代向原始图像添加高斯噪声,最终将图像完全转化为纯噪声。

反向过程(去噪):训练神经网络学习如何从纯噪声开始,逐步去除噪声,最终重建出清晰的图像。

2. 潜在扩散模型(LDM)的创新

Stable Diffusion的关键创新在于将扩散过程从像素空间转移到潜在空间:

首先,使用变分自编码器(VAE)将图像编码到低维潜在空间中,大幅减少计算量。然后,在潜在空间中进行扩散过程,最后通过解码器将潜在表示转换回像素空间。这种方法将计算需求降低了约48倍,同时保持了图像质量。

3. 文本编码与交叉注意力机制

Stable Diffusion使用CLIP文本编码器将输入的文字描述转换为数值表示(嵌入向量)。通过交叉注意力机制,这些文本嵌入被注入到UNet去噪网络的每一层,指导图像生成过程与文本描述保持一致。

主要功能与特性

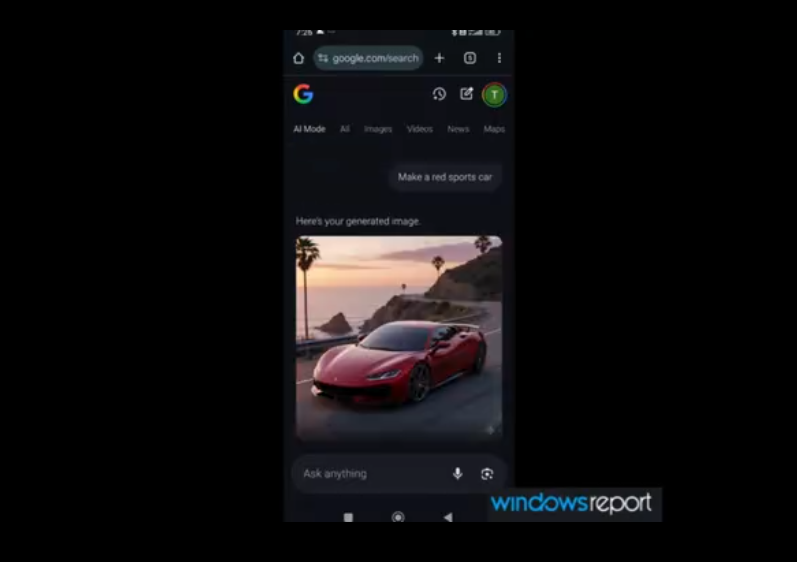

1. 文本到图像生成(Text-to-Image)

用户输入自然语言描述(提示词),模型即可生成与之匹配的图像。提示词工程(Prompt Engineering)成为影响输出质量的关键因素,包括主体描述、风格指定、细节修饰等。

2. 图像修复(Inpainting)

允许用户选择图像的特定区域并进行重新生成或修改,同时保持其余部分不变。这一功能在照片编辑和概念设计中有广泛应用。

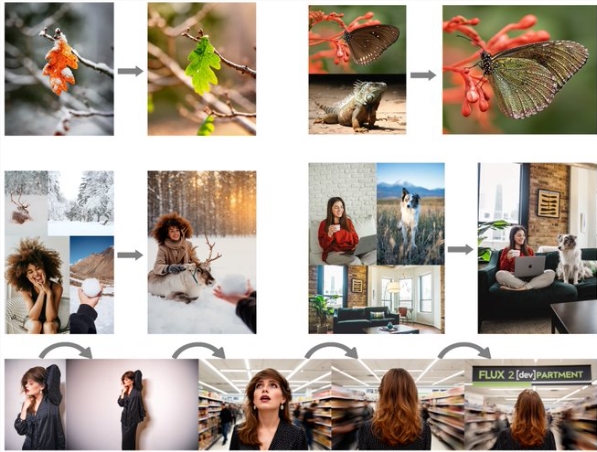

3. 图像到图像转换(Img2Img)

基于现有图像和文本提示生成新图像,可用于风格迁移、分辨率提升、内容修改等任务。

4. 超分辨率增强

通过潜在扩散放大技术,Stable Diffusion能够将低分辨率图像转换为高分辨率版本,同时添加合理的细节。

优势与创新点

1. 开源生态

Stable Diffusion完全开源,包括模型权重、训练代码和推理代码。这促进了全球开发者社区的协作创新,催生了大量衍生项目和定制化版本。

2. 硬件可访问性

相比其他大型模型需要高端服务器GPU,Stable Diffusion可在消费级GPU(最低4GB显存)上运行,大大降低了使用门槛。

3. 高度可定制性

用户可以通过微调(Fine-tuning)在特定数据集上训练自定义模型,生成特定风格或主题的图像。LoRA(Low-Rank Adaptation)等技术的出现进一步降低了定制化成本。

4. 实时生成能力

优化后的实现可在几秒内生成512x512像素的图像,支持交互式创作流程。

实际应用场景

1. 数字艺术与设计

艺术家和设计师使用Stable Diffusion快速生成概念图、插图和设计元素,大大加速创作过程。

2. 游戏开发

独立游戏开发者利用其生成角色设计、场景概念图和纹理素材,降低美术资源制作成本。

3. 营销与广告

快速生成产品宣传图、广告创意和社交媒体内容,实现个性化营销素材的大规模生产。

4. 教育与研究

教育工作者使用AI生成可视化教学材料,研究人员则探索其在科学可视化中的应用。

5. 个人创作与娱乐

普通用户能够轻松将想象力转化为视觉作品,享受AI辅助创作的乐趣。

使用指南与最佳实践

1. 提示词编写技巧

有效的提示词应包含:主体描述、细节特征、艺术风格、画质要求和负面提示。例如:"一位穿着维多利亚时代裙子的女性,站在雾蒙蒙的伦敦街头,电影灯光,35mm胶片,高质量,8k"。

2. 参数调整策略

关键参数包括:采样步数(20-30步平衡质量与速度)、CFG scale(7-12指导强度)、种子值(控制随机性)和采样器选择(推荐DPM++ 2M Karras或DDIM)。

3. 工作流优化

高级用户常采用多阶段生成:先生成低分辨率草图,再通过Img2Img和超分辨率逐步细化,最后使用inpainting进行局部调整。

伦理考量与挑战

尽管Stable Diffusion带来了巨大创新,但也面临一系列伦理挑战:

版权问题:训练数据中可能包含受版权保护的作品,引发关于公平使用和艺术家补偿的讨论。

misinformation风险:技术可能被滥用生成虚假信息或深度伪造内容。

偏见与代表性:模型可能反映训练数据中的社会偏见,需要持续监控和修正。

Stability AI通过实施内容过滤机制和提倡负责任使用指南来应对这些挑战。

生态系统与未来发展

Stable Diffusion的生态系统日益丰富,包括:

WebUI界面:如AUTOMATIC1111和ComfyUI,提供用户友好的操作环境。

移动端应用:多家公司开发了iOS和Android应用,使移动设备也能运行Stable Diffusion。

云服务集成:AWS、Google Cloud等平台提供托管服务,降低部署难度。

未来发展方向包括:视频生成、3D模型生成、更长序列的连贯性生成,以及与AR/VR技术的深度融合。

结语

Stable Diffusion代表了AI民主化的重要里程碑,它将曾经只有大型科技公司才能拥有的尖端技术带给全球创作者。其开源本质不仅加速了技术创新,还培养了活跃的社区文化,推动着整个领域向前发展。随着技术的不断成熟和应用的深入,Stable Diffusion将继续重塑我们创造和消费视觉内容的方式,为数字创意领域开启无限可能。

无论您是开发者、艺术家还是技术爱好者,现在都是探索和参与这一革命性技术的最佳时机。Stable Diffusion不仅仅是一个工具,更是通往想象力新维度的门户,邀请每个人成为AI增强创作时代的积极参与者。